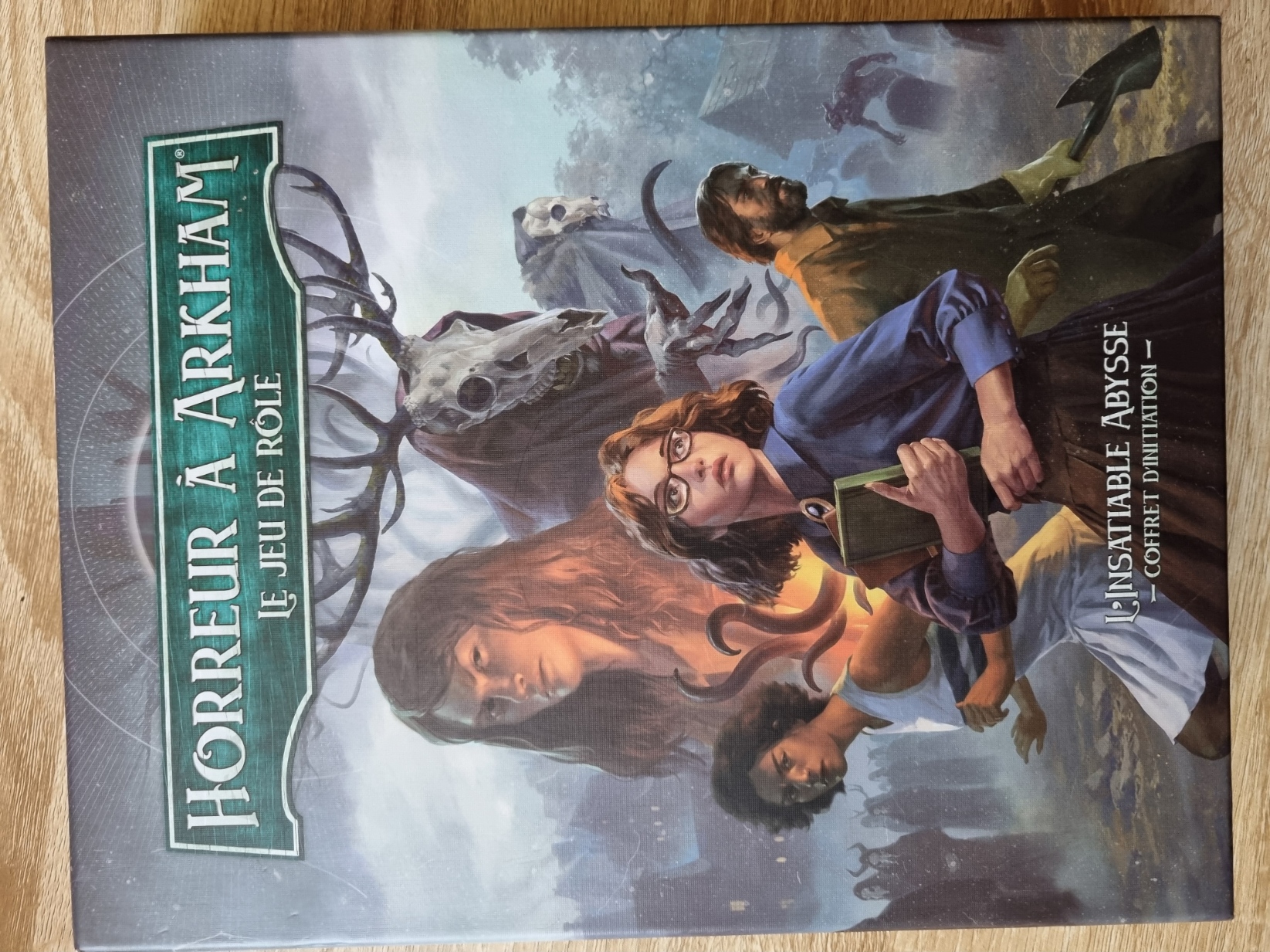

Petite critique rapide de Horreur à Arkham, le jeu de rôle, tiré du jeu de société du même nom, lui-même inspiré du jeu de rôle L’Appel de Cthulhu, lui-même écrit d’après les nouvelles de notre cher H.P. Lovecraft. Eeet la boucle est bouclée.

Je n’avais pas entendu parler de ce jeu, ou très peu, et c’est en regardant la boîte dans un magasin que j’ai été intrigué. Une très jolie boîte en carton épais, émanation d’un jeu de société que j’aime beaucoup malgré sa punitivité et sa complexité — j’ai évidemment craqué.

Unboxing

Alors, quoi qu’il y a là-dedans ?

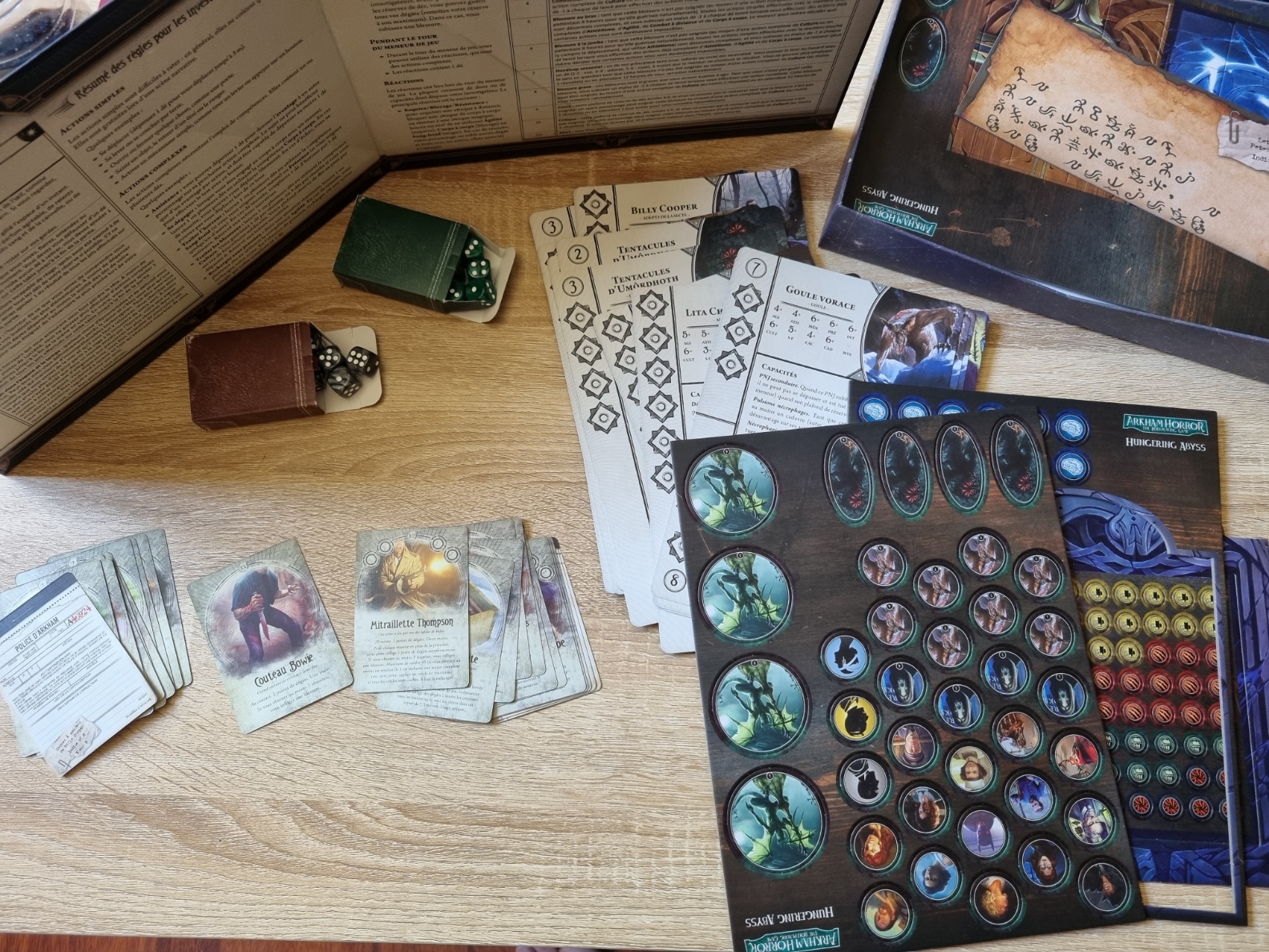

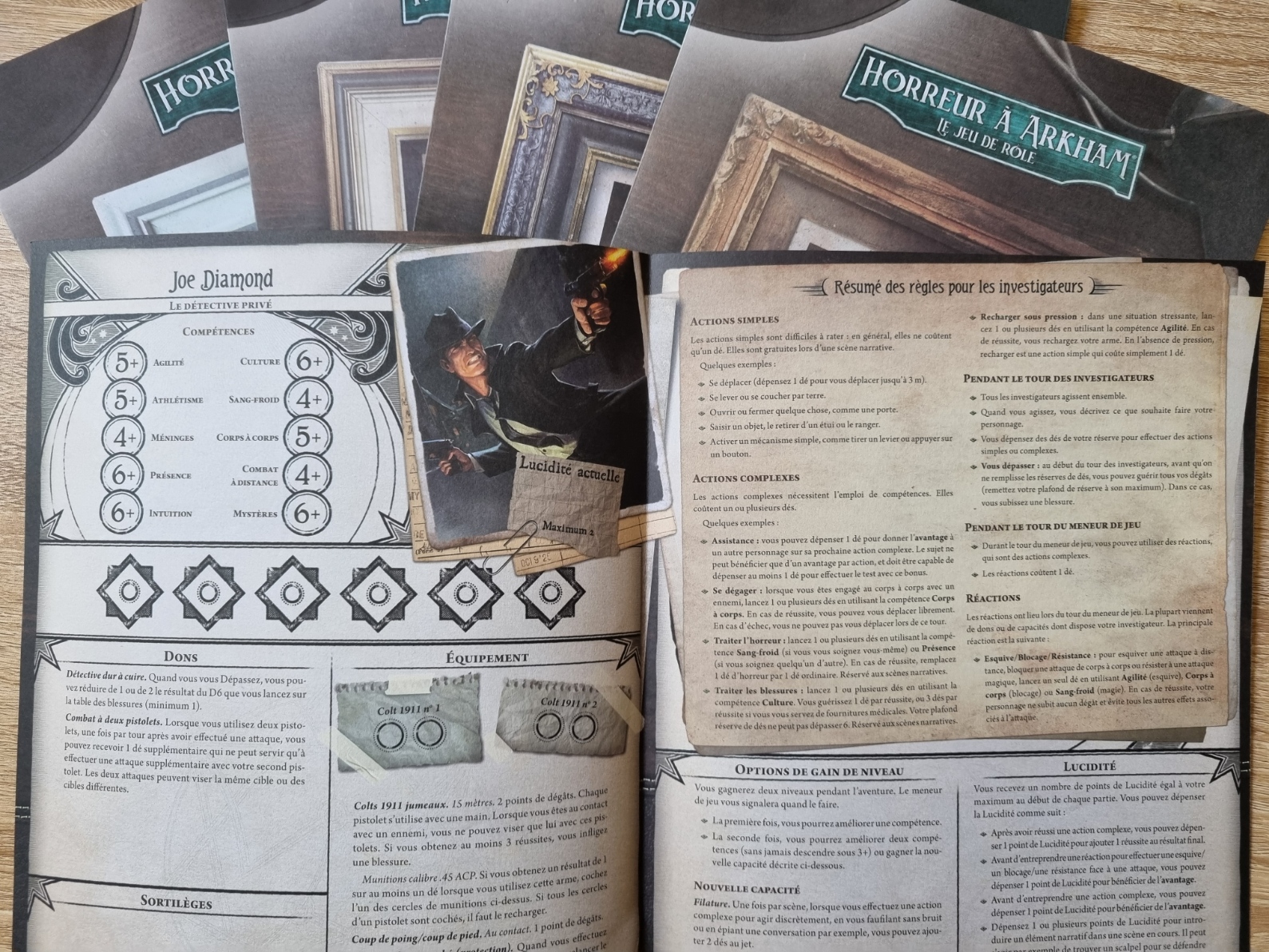

Eh bien, plein de choses. La boîte est bien remplie, le matériel est de très bonne qualité. Notamment, les cartes sont imprimées sur un papier très épais, limite bristol. Il y a des pions sur un carton très épais aussi, cinq feuilles de personnages avec tout ce qu’il faut pour jouer. Elles se présentent sous la forme d’un A3 plié en deux (j’ai dit que le papier était TRÈS épais), et contiennent toutes les bonnes informations : les caracs, le matos d’origine, les règles importantes, les montées de niveau… tout y est.

Il y a deux sets de 12 D6 chacun, donc 24 D6, plutôt jolis, 12 noirs et 12 verts. Ça semble faire beaucoup, mais vu qu’il en faut au moins 6 par perso, en vrai ce n’est même pas suffisant. J’en parlerai après, mais à cause d’une astuce de jeu, c’est compliqué de se les prêter. Ensuite, on trouve les cartes de monstres, parfaites, épaisses, solides, avec illustrations, motivations, et infos techniques. Et enfin, les cartes de matériel : les armes, armures et autres trucs qui font boum. Je rêverais d’une telle qualité pour mes cartes YxY.

On termine par l’aventure elle-même, sous la forme d’un livret cousu, un peu chelou d’ailleurs. La couture n’est pas super, y’a un fil qui dépasse, c’est vraiment bizarre par rapport à la qualité globale du machin.

Il n’y a pas de bouquin de règles à part, celles-ci étant incluses dans l’aventure.

Les illustrations sont absolument magnifiques, la maquette lisible, et j’ai dû voir une seule typo dans l’immensité du texte, ce qui est une sorte d’exploit…

Il faut savoir que je suis fan de matériel de jeu, surtout pour du Cthulhu. Je me souviens de parties où le frisson venait plus de la découverte d’un vieux carnet coincé derrière un meuble ou d’un message codé que le MJ avait imprimé sur un papier vieilli, que de la description d’un monstre vu déjà 100 fois.

Là, c’est un peu pareil : on a plein de matériel de jeu, et toutes les aides de jeu, tous les indices sont matérialisés.

Les règles

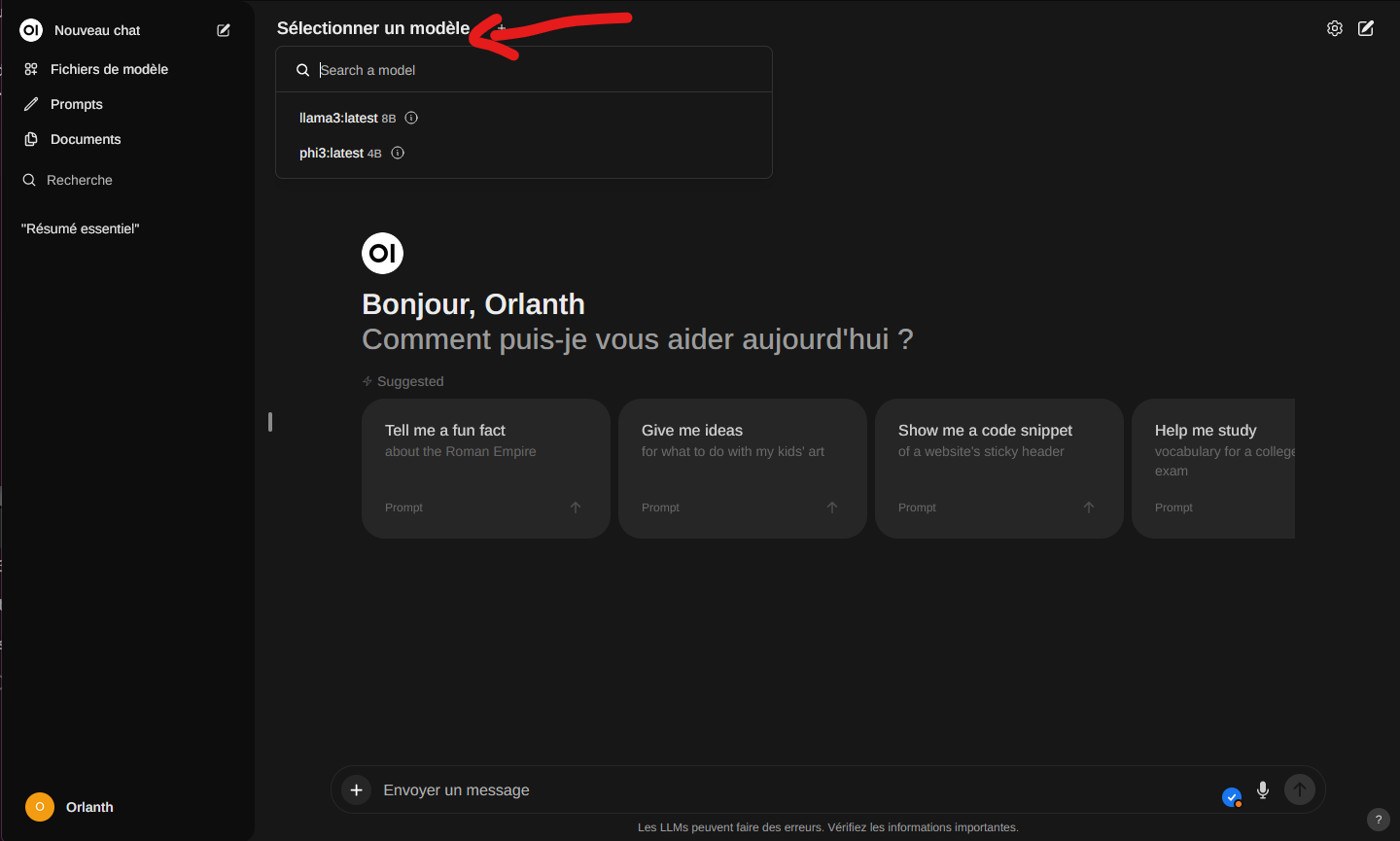

Les règles sont présentées dans les deux premiers actes du scénario (qui en comporte trois).

Elles ne sont pas très compliquées en soi, mais parfois un peu rigides dans leur explication. Typiquement, il existe trois types de scènes :

- les simples, où tu parles et fais des actions évidentes (ouvrir une porte, répondre au téléphone),

- les complexes, qui nécessitent des jets de dés,

- les structurées, principalement les combats. La structure vient du découpage en rounds, nécessaire pour les scènes de bagarre.

Chaque joueur possède une réserve de dés : 6 s’il est en bonne santé, et de moins en moins au fur et à mesure des dégâts physiques encaissés. C’est très élégant et très visuel. Un perso avec 3 dés restants n’est clairement pas bien.

Les dégâts psychiques, dits d’horreur, remplacent les dés normaux par des dés verts. Si ces dés font 1, le personnage chope des traumas. Ce qui peut l’inciter à ne pas agir, justement pour éviter de lancer des dés. Idem, c’est plutôt élégant : j’aime quand la technique produit des effets de jeu ou incite à un certain comportement.

En dehors de ça, pour réussir une action, le personnage choisit un nombre de dés à lancer (jusqu’à son max). Chaque dé qui égale ou dépasse sa caractéristique est une réussite. Plus y’en a, mieux c’est.

Exemple : Joe tire au fusil de chasse sur le Byakhee méchant. Il choisit de lancer 4 dés (il a été blessé d’un point précédemment et veut en garder un pour se défendre), fait trois réussites, ce qui entame la créature et lui occasionne une blessure directement.

On peut garder des dés pour se défendre lors du tour de l’adversaire. Et les dégâts sont fixes en fonction de l’arme.

Juste une petite précision manquante : il me semble qu’on ne peut faire qu’une action par tour. Pas question de faire six attaques à un dé chacune, par exemple.

Dans les scènes structurées, on récupère tous ses dés à chaque round. Tandis que dans les scènes complexes, on récupère tous ses dés en une fois, quand le MJ décide que la scène avance. C’est pas mal, parce que ça oblige tout le monde à jouer et à dépenser ses dés. (Si Michel a dépensé 5 dés et Marc 2, on voit bien qu’il reste du temps à Marc, qui devrait trouver des choses à faire avant que la scène n’avance ou se termine.)

La gestion du temps est donc matérialisée par les mêmes dés, et encore une fois, je trouve ça élégant.

Enfin, le système de combat prévoit des battlemaps (des plans avec des cases), des déplacements précis case par case, des portées d’arme, etc. Ce n’est pas du tout ma came, mais ça aide certains joueurs à mieux visualiser ce qu’il se passe et où ils se trouvent.

Les personnages

Les cinq personnages présentés sont pré-tirés. Les joueurs n’ont rien d’autre à faire que de choisir celui qui leur plaît et de démarrer immédiatement. Il n’y a pas de système de création de personnage, et les évolutions sont conditionnées par le scénario lui-même.

Toute la palette classique de Cthulhu s’y retrouve : une lanceuse de sorts, un détective, une combattante au contact, un fossoyeur et une psychologue. Tous les personnages sont expérimentés et connaissent le surnaturel ou sont prêts à l’affronter rapidement. Pas question de se lancer en débutant tout frais. Même les règles de santé mentale sont un peu plus permissives que d’habitude.

Les personnages sont intégrés dans le scénario, et à plusieurs reprises, il sera fait mention de contacts que l’un ou l’autre pourrait avoir, les aidant dans la situation en cours.

L’aventure

À mon humble avis, c’est là que cela pêche un peu.

C’est un scénario ultra-classique pour débutant complet. Il y a zéro originalité : une secte de méchants veut invoquer un Ancien, il faut leur péter la mouille et arrêter le rituel. Fin.

En lisant le scénario, on retrouve les mêmes idées et développements qu’on pouvait lire il y a 30 ans avec Star Wars D6 : des paragraphes et des scènes très découpés, des lignes à lire ou paraphraser aux joueurs, des explications réduisant au maximum les frictions. On sent bien que c’est fait pour accompagner un maître de jeu (et des joueurs) qui se lanceraient pour la première fois. Ce n’est absolument pas un mal, mais c’est à savoir.

Il n’y a d’ailleurs qu’un seul scénario. Même s’il est complet, avec du matos de partout, c’est un peu chiche. J’aurais bien aimé avoir des idées de suite, à la manière du jeu de société qui présente des campagnes absolument fantastiques.

Par contre, tout y est : des battlemaps pour chaque lieu décrit, des fiches de monstres pour tous les PNJ rencontrés, des pions/figurines à placer, etc.

Il y a même des puzzles à résoudre, physiquement !

Conclusion

J’ai beaucoup aimé le matériel, la prise en main pour les débutants, et la promesse implicite de continuer à proposer une telle qualité de fabrication.

Je ne suis pas convaincu par le scénario lui-même, ni finalement par les règles. Elles ne sont pas mauvaises, loin de là : elles ne sont pas trop compliquées, élégantes, et proposent des possibilités de prises de risque. Mais je ne vois pas l’intérêt par rapport aux systèmes existants.

Le jeu est à 35€, et promet sans doute une à deux belles séances de jeu, ce qui n’est pas cher par rapport à la qualité du matériel.

C’est bien sûr parfaitement traduit (merci Sandy Julien).

En attendant de voir la suite, je conseillerais cette boîte aux débutants ou semi-débutants qui veulent découvrir Cthulhu et/ou un jeu de rôle qui n’est pas D&D.